대규모 추론의 원가 구조를 H100 가정, MoE 활성 파라미터, 배치·병렬화 전략을 바탕으로 역산해 입력·출력 토큰의 비용 비대칭을 정리하고, 소비자 플랜·개발자 워크로드·API 가격의 수익성을 가늠한다.

AI가 얼마나 현금소각기인 지, 특히 추론(inference) 쪽에서 그렇다는 얘기를 계속 듣는다. 겉보기에 합리적으로 들리지만, 나는 늘 이런 주장에 회의적이었고, 그래서 조금 파고들어 보기로 했다.

대규모 추론을 운영할 때의 비용을 제대로 분해하려는 시도는 아직 거의 못 봤고, 이런 경제학은 개인적으로 매우 흥미롭다.

이건 정말로 ‘냅킨 계산’이다. 최전선 모델을 대규모로 운영한 경험은 없지만, 클라우드에서 초고처리량 서비스를 운영하는 비용과 경제 구조, 그리고 하이퍼스케일러 대비 베어메탈에서의 말도 안 되는 마진에 대해선 꽤 잘 안다. 정정 환영.

순수 계산(컴퓨트) 비용만 본다. 엄청난 단순화라는 걸 안다. 그래도 현재 모델들이 얼마나 유용한지 — 개선이 전혀 없다고 가정하더라도 — 모두가 추론에서 그렇게 큰손해를 보고 있어 지속 불가능하다는 주장을 스트레스 테스트해 보고 싶다.

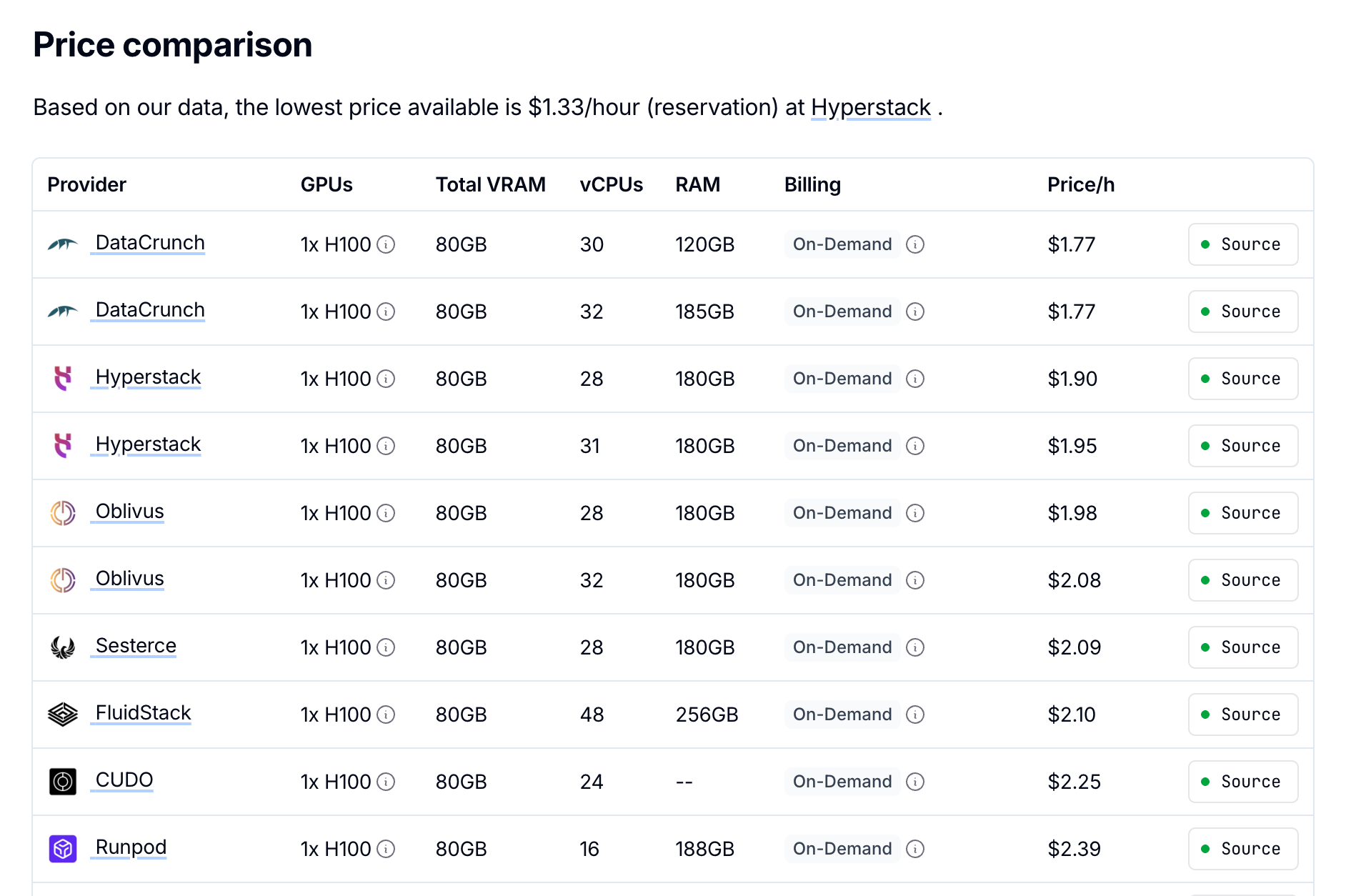

단일 H100 비용을 시간당 2달러로 잡았다. 이는 현재 리테일 온디맨드 대여가보다도 높은 수치이고, 대형 AI 기업들은 이보다 훨씬 낮은 가격에 조달하리라(바란다).

두 번째로, DeepSeek R1의 아키텍처를 기준선으로 쓴다. 총 671B 파라미터에 MoE로 활성 37B. 이는 Claude Sonnet 4와 GPT-5에 다소 근접한 성능을 보이므로 합리적인 가정이라 본다.

현실적인 프로덕션 구성을 가정해 보자. H100 72장 클러스터, 장당 시간당 2달러로 총 비용은 시간당 144달러.

프로덕션 지연(latency) 요구 사항을 위해, 모델 인스턴스당 동시 요청 배치를 32로 잡는다. 벤치마크에서 보이는 거대한 배치보다 현실적이다. 모델 인스턴스당 8 GPU 텐서 병렬을 쓰면, 72 GPU로 동시에 9개 인스턴스를 돌릴 수 있다.

H100의 HBM 대역폭은 GPU당 약 3.35TB/s로, 대부분의 워크로드에서 병목이 된다. 활성 파라미터 37B는 FP16 정밀도에서 74GB를 요구하므로, 대략 3,350GB/s ÷ 74GB = 인스턴스당 초당 45회 포워드 패스를 밀어 넣을 수 있다.

핵심 인사이트: 각 포워드 패스는 배치의 모든 시퀀스의 모든 토큰을 동시에 처리한다. 배치 32, 시퀀스 평균 1,000토큰이면, 포워드 패스당 32,000토큰을 처리한다. 즉, 인스턴스당 45회/초 × 32k 토큰 = 초당 144만 개 입력 토큰을 소화할 수 있다. 인스턴스 9개면 초당 약 1,300만 입력 토큰, 시간당 468억 입력 토큰이다.

실제로 MoE에선 배치 내 토큰마다 다른 전문가 조합을 적재해야 할 수 있어, 라우팅이 다양하면 처리량이 23배 줄어들 수 있다. 다만 실전 라우팅 패턴은 인기 전문가로의 군집이 나타나는 경향이 있고, 최신 구현은 전문가 병렬화와 capacity factor 같은 기법으로 효율을 유지한다. 그래서 실제 영향은 최악보다는 작게, 대략 3050% 감소에 가까울 가능성이 높다.

출력 생성은 완전히 다른 양상이다. 토큰을 순차적으로 만든다 — 포워드 패스당 시퀀스 하나당 토큰 하나다. 그래서 초당 45회 포워드 패스는 인스턴스당 45 × 32 = 초당 1,440개 출력 토큰만 만든다. 9개 인스턴스면 초당 12,960개, 시간당 4,670만 개 출력 토큰이다.

비대칭이 선명하다: 144달러 ÷ 46,800M = 백만 입력 토큰당 0.003달러 vs 144달러 ÷ 46.7M = 백만 출력 토큰당 3.08달러. 무려 천 배 차이!

위 계산은 메모리 대역폭이 병목이라는 가정에 기반한다. 일반적으론 타당하지만, 특정 시나리오에선 연산이 병목이 된다. 아주 긴 컨텍스트에선 어텐션 계산이 시퀀스 길이의 제곱에 비례해 늘어난다. 대형 배치로 병렬 어텐션 헤드가 늘어나도 연산 병목으로 기울 수 있다.

컨텍스트 길이가 128k+를 넘기면 어텐션 행렬이 거대해지고, 메모리 병목에서 연산 병목으로 전환한다. 아주 긴 컨텍스트에선 비용이 2~10배까지 뛸 수 있다.

이는 몇 가지 흥미로운 제품 결정을 설명한다. Claude Code가 컨텍스트를 인위적으로 200k 토큰으로 제한하는 건 단지 성능 때문만이 아니라, 추론을 저렴한 메모리 병목 구간에 묶어 두고 고가의 연산 병목 장거리 컨텍스트를 피하려는 목적도 있다. 제공사들이 200k+ 컨텍스트 창에 추가 요금을 붙이는 이유도 같다 — 경제학이 근본적으로 달라지기 때문이다.

정리하면, 다음이 사실일 가능성이 높다고 본다(다시 말하지만, 이건 H100 리테일 대여가 기준이다):

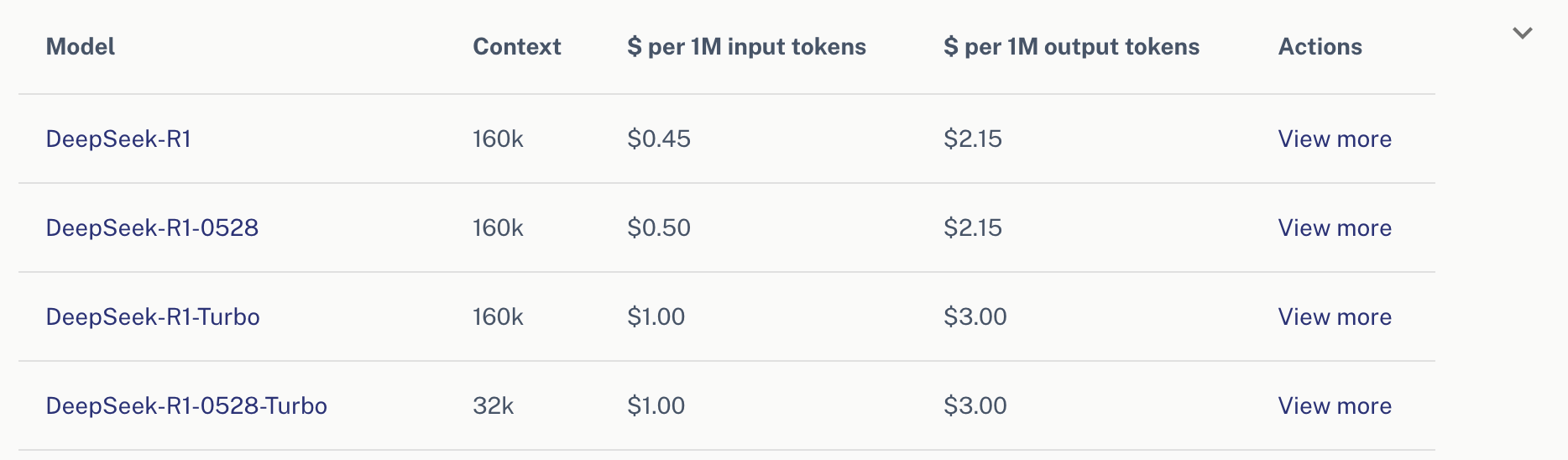

이 비용 구조는 R1 호스팅에 대한 DeepInfra의 과금과도 들어맞는다. 다만 입력 토큰에 더 높은 마진이 얹혀 있다.

전형적인 파워 유저다. 매일 글쓰기, 코딩, 일반 질의에 모델을 쓰는 경우. 여기의 경제성은 탄탄하다.

Claude Code Max 5 사용자(월 100달러): 하루 2시간 헤비 코딩

Claude Code Max 10 사용자(월 200달러): 하루 6시간 매우 헤비 사용

개발자 유스케이스에서 경제성이 특히 빛난다. Claude Code 같은 코딩 에이전트는 사용 패턴이 극도로 비대칭적이다 — 전체 코드베이스, 문서, 스택 트레이스, 여러 파일, 방대한 컨텍스트를 집어넣고(저렴한 입력 토큰), 필요한 출력은 코드 스니펫이나 설명처럼 작다. 입력이 거의 공짜이고 출력이 비싼 비용 구조에 딱 맞는다.

API 사업은 사실상 머니 프린터에 가깝다. 이익률은 인프라가 아니라 소프트웨어에 가깝다.

이 분석엔 많은 가정이 있고, 몇몇은 틀렸을 수도 있다. 그래도 3배 정도 오차를 감안하더라도 경제성은 여전히 매우 수익성 있어 보인다. 리테일 H100 가격조차 기준으로 삼아도, AI 추론은 많은 이들이 주장하듯 지속 불가능한 돈 먹는 하마가 아니다.

대부분이 놓치는 핵심 인사이트는 입력 처리 비용이 출력 생성에 비해 얼마나 극적으로 저렴한지다. 천 배 차이에 가깝다 — 입력 토큰은 백만 당 대략 0.005달러, 출력 토큰은 백만 당 3달러+.

이 비용 비대칭은 어떤 유스케이스는 엄청나게 수익성이 높은 반면, 다른 것들은 고전할 수 있는 이유를 설명한다. ‘많이 읽고 적게 쓰는’ 애플리케이션 — 방대한 컨텍스트를 소비하지만 출력은 최소 — 은 컴퓨트 비용 측면에서 거의 무료에 가깝다. 대화형 에이전트, 전체 코드베이스를 처리하는 코딩 도우미, 문서 분석 도구, 리서치 애플리케이션 모두 이 구조의 큰 수혜자다.

비디오 생성은 이 비용 구조의 정반대 극단을 대표한다. 비디오 모델은 입력으로 간단한 텍스트 프롬프트 — 어쩌면 50토큰 — 만 받지만, 각 프레임을 표현하는 수백만 토큰을 생성해야 할 수 있다. 작은 입력으로 거대한 출력을 만들어야 하니 경제성이 가혹해진다. 그래서 비디오 생성이 여전히 비싸고, 프리미엄 가격을 받거나 사용을 강하게 제한하는 서비스가 많은 것이다.

‘AI는 감당할 수 없을 정도로 비싸다’는 내러티브는 경제 현실보다는 기득권의 이해관계에 더 봉사하고 있을지도 모른다. 거대 사업자가 막대한 비용과 기술적 복잡성을 강조하면, 경쟁과 대안에 대한 투자를 꺼리게 만든다. 하지만 우리의 계산이 조금이라도 맞는다면, 특히 입력 위주 워크로드에선 수익성 있는 AI 추론으로 가는 장벽이 흔히 믿는 것보다 훨씬 낮을 수 있다.

비용을 지나치게 과장해 원초적 경제학을 못 보게 만들지 말자. 10~20년 전 클라우드 컴퓨팅 비용에서 모두가 한 번 속았고, 그 결과 하이퍼스케일러들이 머니 프린터가 되도록 허용했다. AI 추론에서도 같은 일을 반복하지 않도록 조심해야 한다.