Q-learning 기반의 오프폴리시 강화학습(RL)은 다른 AI 목표처럼 대규모로 확장되지 않는다. 그 이유, 현재 한계, 그리고 앞으로의 알고리즘 혁신이 필요한 이유를 살펴본다.

지난 몇 년 동안, 다음 토큰 예측(next-token prediction), 노이즈 제거 확산(denoising diffusion), 대조학습(contrastive learning) 등 다양한 목적함수들이 규모의 경제를 타는 것이 확인되었습니다. 이제는 수십억 개의 파라미터를 가진 모델을, 원하는 만큼 많은 데이터를 투입해 훈련할 수 있는 확장 가능한 목표로 학습시킬 수 있습니다. 그렇다면 강화학습(RL)은 어떨까요? 강화학습 역시 다른 목적들처럼 확장 될까요?

겉보기엔 그렇습니다. 2016년에 RL은 바둑과 체스에서 인간을 능가하는 수준에 도달했습니다. 최근에는 대형 언어모델(LLM)과 결합되어 수학 및 코딩 등 복잡한 추론 잡업도 해결하고 있습니다. 놀라운 진전이지만, 중요한 전제가 있습니다. 현재 RL의 현장 성공 사례의 대부분은 전형적으로 온폴리시 RL 알고리즘(예: REINFORCE, PPO, GRPO 등)을 사용한다는 점입니다. 이 방법들은 항상 새로 샘플링한 정책롤아웃만 사용할 수 있고, 과거 데이터를 재사용하지 못합니다(참고: PPO 류도 아주 일부 데이터는 재사용할 수 있지만, OpenAI 공식문서 등에서는 온폴리시 RL로 분류합니다). 이렇게 새 데이터 생성이 쉬운 보드게임/LLM 등에서는 별문제 없지만, 현실의 대부분 영역(로봇 등)에서는 중대한 제약이 됩니다. 예를 들어 로봇의 RL 학습에 필요한 샘플을 현실에서 모으려면 수개월 이상이 걸릴 뿐더러, 사람이 24시간 대기해 계속 리셋해줘야 합니다.

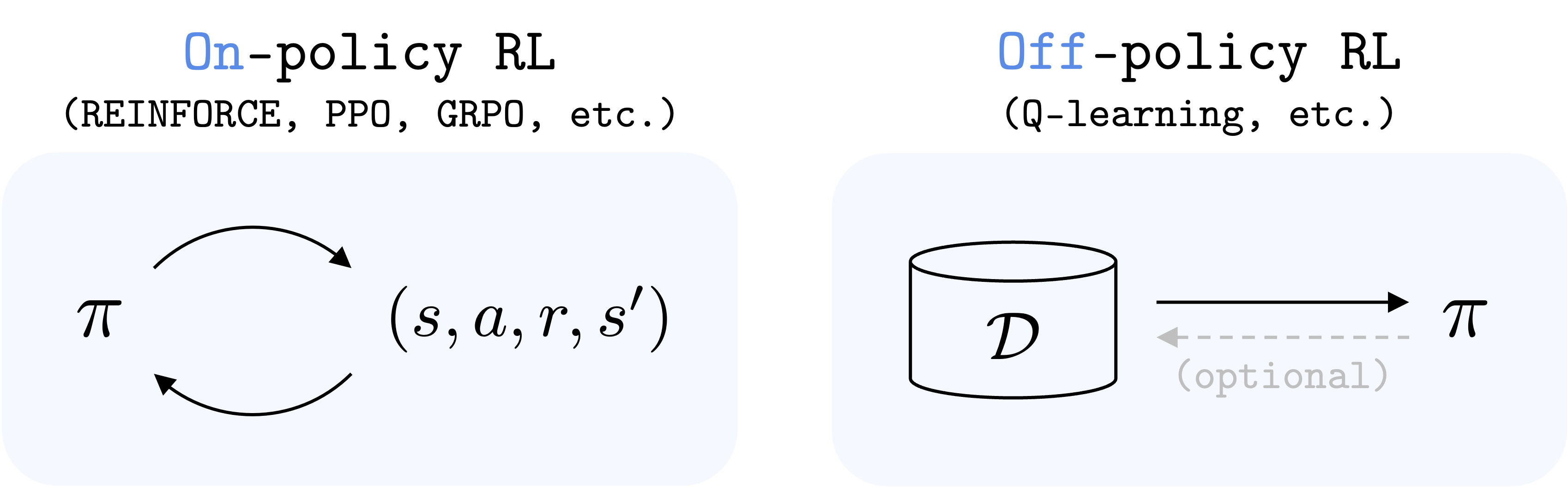

온폴리시 RL은 오직 현 정책에서 수집한 신선한 데이터만 사용할 수 있는 반면, 오프폴리시 RL은 어떤 데이터든 재사용할 수 있습니다.

이 시점에서 오프폴리시 RL이 구원투수로 떠오릅니다. 원칙적으로 오프폴리시 RL 알고리즘은 데이터가 언제, 어떻게 수집됐건 재사용할 수 있습니다. 따라서 데이터 효율성이 훨씬 높아지며, 동일한 데이터를 여러 번 사용합니다. 실제로 오프폴리시 RL은 개 로봇을 현실에서 20분 만에 걷게 만든 사례도 있습니다. Q-learning이 그 중 가장 널리 쓰이는 오프폴리시 RL 알고리즘입니다. Q-learning은 타겟 네트워크 파라미터 를 써서 아래와 같은 temporal difference(TD) 손실을 최소화합니다. 대부분의 실제 오프폴리시 RL(모델프리)도 이 TD 손실의 변형입니다. 그래서 현실 문제에 RL을 적용하려면, 핵심 질문이 이렇게 바뀝니다: Q-learning(TD learning)은 확장 가능한가? 만약 그렇다면, AlphaGo나 LLM의 성공 못지않은 임팩트로, 훨씬 다양한 현실 문제(로봇, 에이전트 등)를 아주 효율적으로 풀 수 있게 될 것입니다.

아쉽게도 제 현재 생각은 아직은 아니다입니다. 현행 Q-learning 알고리즘은 적어도 장기 시계열(롱-호라이즌) 문제(예: 100회 이상의 시맨틱 결정)가 필요한 케이스에서는 쉽게 확장되지 않는다고 생각합니다.

여기서 말하는 확장성이란, 더 많은 데이터(충분히 다양함), 컴퓨트, 시간 투입 시 더 어려운, 장기 문제를 풀 수 있는 능력입니다. 이는 단일 모델로 _문제의 수_를 많이 푸는(난이도는 늘어나지 않는) 능력과는 다릅니다. 전자를 "깊이(depth)" 축, 후자를 "넓이(width)" 축이라 볼 수 있습니다. RL 연구자가 "깊이 축"을 확장하는 것이 더 어렵고 중요하다고 보는 이유는, 보다 높은 수준의 의사결정 능력이 필요하기 때문입니다.

제 주장: Q-learning(오프폴리시 RL)은 현 상태로는 깊이 축에서 고도 확장이 어렵다. 즉, Q-learning을 복잡한 롱-호라이즌 문제로 확장하려면 _알고리즘 혁신_이 필요하다 봅니다. 왜냐하면, 두 가지 주요 이유가 있어서인데, 그 중 하나는 경험적(anecdotal)이, 하나는 저희 최근 스케일링 연구에 근거합니다.

AlphaGo와 DeepSeek 모두 온폴리시 RL 기반이며, TD learning을 쓰지 않는다.

우선 경험적 증거입니다. 위에 썼듯, 현존하는 RL의 현실 성공 대부분은 온폴리시 RL입니다. AlphaGo, AlphaZero, MuZero 등은 모델기반 RL + 몬테카를로 트리서치 기반이고, 바둑/체스 등에서는 TD learning을 사용하지 않습니다(MuZero 15쪽 참조). OpenAI Five는 Dota 2에서 PPO(온폴리시)로 초인적 성능을 냈습니다(OpenAI Five 논문 6번 주석 참고). LLM 강화학습도 주로 PPO, GRPO 등 온폴리시 정책경사 계열이 지배적입니다. _오프폴리시 RL(특히 1-스텝 TD learning)_이 AlphaGo, LLM급 현실 임팩트를 낸 케이스를 혹시 알고 계신가요? 아시면 꼭 알려주세요! (그러면 글을 수정하겠습니다)

물론 이런 주장에 일화적 증거만 드는 것은 아닙니다. 곧 경험적 실험 결과도 보여드릴 예정입니다. 그리고 오해 마세요, 저는 오프폴리시 RL, Q-learning의 미래에 여전히 매우 낙관적입니다(주로 이 분야 연구자로서!). 단지, _아직 거기에 도달하지 못했다_고 보고, 이 글의 목적은 RL 알고리즘 R&D를 권장하기 위함임을 밝힙니다.

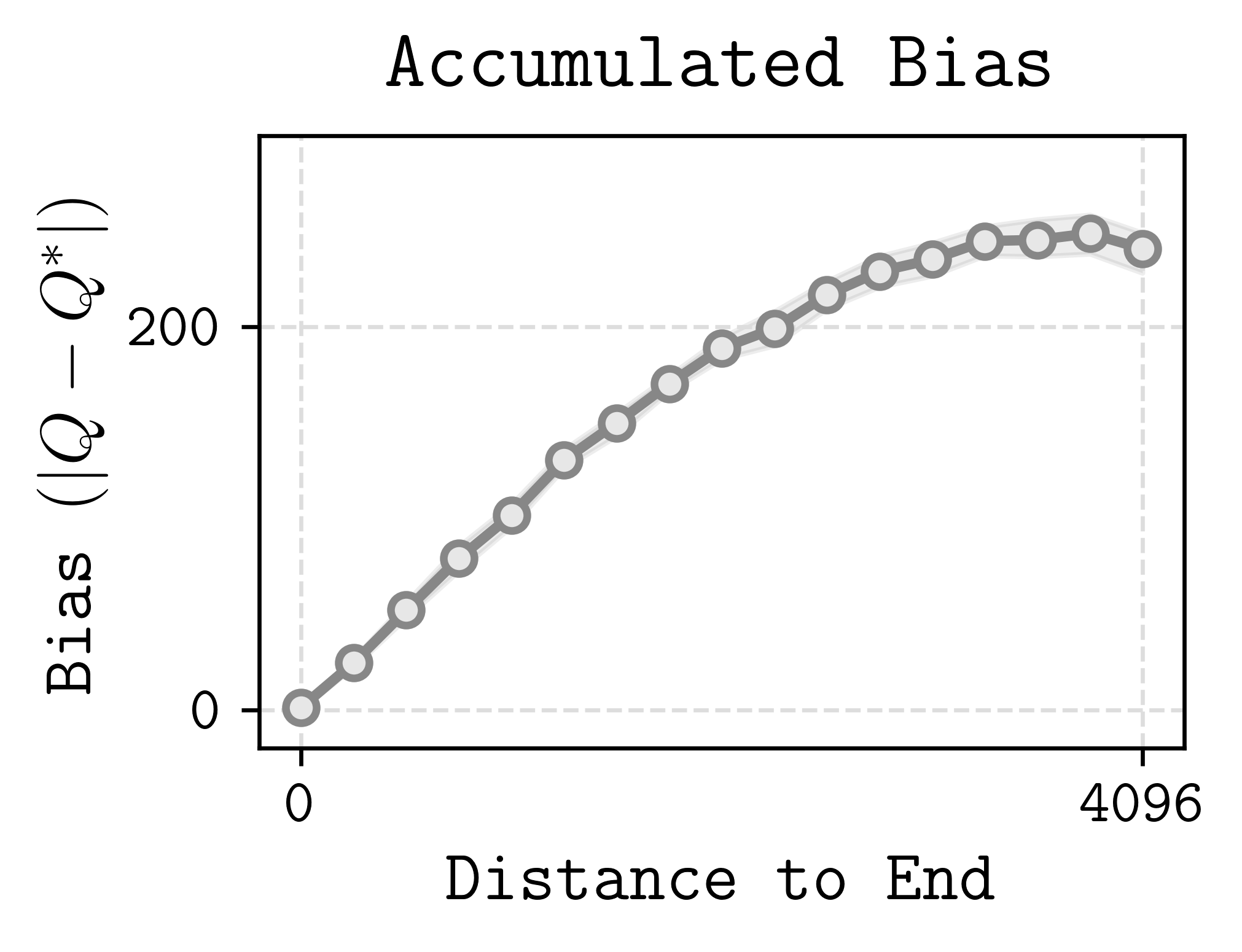

그럼 다른 목적과 달리, 왜 Q-learning(및 TD learning)은 복잡하고 롱-호라이즌 문제에서 즉시 확장되지 않을까요? 제 답은 이렇습니다: Q-learning이 확장에 약한 이유는 예측 타깃이 편향(bias)돼 있고, 이 편향이 _시계열을 따라 누적_되기 때문입니다. 이런 편향 누적(bias accumulation) 현상은 Q-learning(및 TD learning)만의 고유한 한계입니다. 예를 들어, 토큰 예측, 노이즈 제거, 대조학습 등 _다른 확장 가능한 목표_는 타깃 편향이 없거나, 있다 해도 시계열 따라 누적되지 않습니다(BYOL, DINO 등).

편향은 에피소드가 길어질수록 누적된다.

문제가 복잡해지고 시계열이 늘어날수록, 부트스트랩 타깃의 편향도 점점 심하게 누적되어, 데이터/모델만 키워선 쉽게 해결이 안 됩니다. 실제로 RL에서 할인계수()를 크게 쓰지 않는 주요 이유, Q-learning의 스케일링이 어려운 근본적 배경이기도 합니다. 참고로 정책경사(policy gradient) 계열은 이 문제에 훨씬 덜 취약합니다. 왜냐하면 GAE나 유사 온폴리시 값추정법 덕분에(분산은 좀 상승하지만) 1-스텝 재귀에 묶이지 않은 채, 좀 더 쉽게 롱-호라이즌을 다룰 수 있기 때문입니다.

저희 최근 논문에서, 위 주장을 직접 다양한 통제실험을 통해 검증했습니다.

데이터와 컴퓨트만 대폭 늘리면, 현행 오프폴리시 RL이 정말 어려운 과제를 풀 수 있을까? 이를 위해 OGBench에 아주 복잡하고, 지금까지 풀린 적 없는 과제를 준비했습니다. 아래는 일부 예시 영상입니다:

cube

cube

puzzle

puzzle

humanoidmaze

humanoidmaze

이 문제들은 정말 어렵습니다. 에이전트는 실수로 주어진, 무작위(플레이 스타일) 시연에서 목표 달성법을 익혀야 하며, 평가 시에는 고난이도의 정밀 조작, 조합 퍼즐 해결 또는 장기 내비게이션(1천 스텝 이상)을 수행해야 합니다.

이 환경들에서 사실상 무한대에 가까운 데이터를 모아, 오버피팅이 거의 불가능한 조건을 만들었습니다. 혼동 요인도 철저히 통제했습니다. 예를 들어, 오프라인 RL만 써서 환경 탐험/탐사 문제를 제거했고, 데이터셋의 커버리지도 충분히 확보했으며, 관찰도 ground-truth state로 직접 제공해 표현학습 부담도 완화했습니다.

즉, 정말 확장 가능한 RL 알고리즘이라면, 데이터와 컴퓨트가 충분할 때 반드시 주어진 문제를 풀어야만 합니다. 만약 Q-learning이 이런 완전히 통제된(무한대 데이터!) 조건에서조차 스케일링에 실패한다면, 현실의 더 제한된 데이터/노이즈 조건에서는 더욱 기대하기 어렵겠죠.

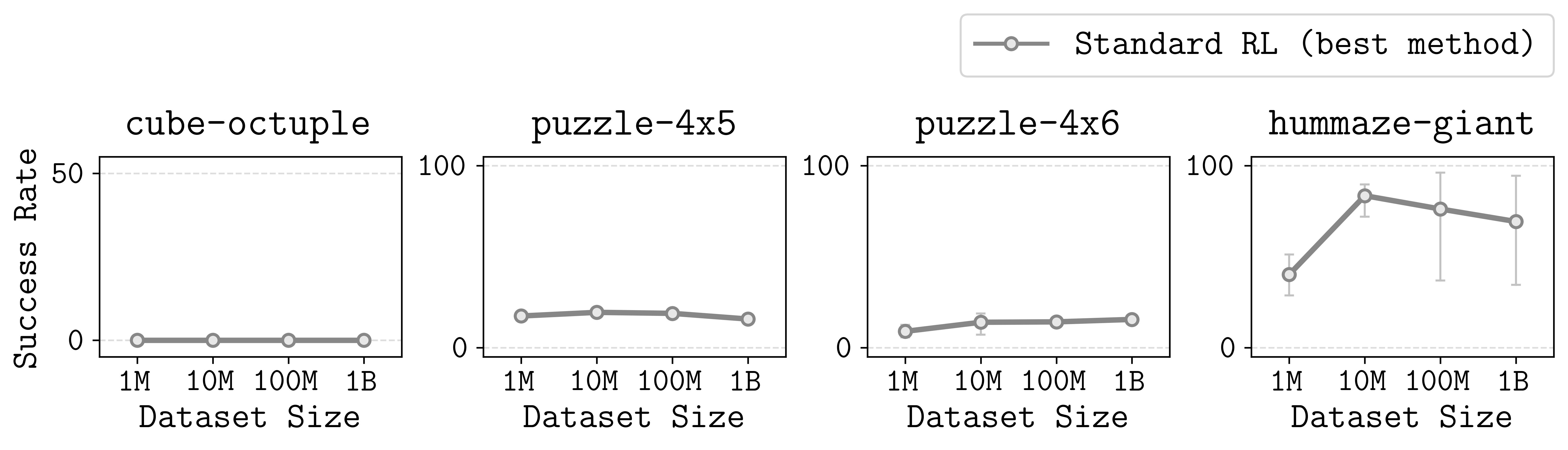

표준 오프라인 RL 알고리즘들은 데이터만 늘려도 복잡한 장기 문제는 해결하지 못하고, 성능이 금방 평탄화(plateau)된다.

실제 결과는 좀 실망스러웠습니다. 널리 쓰이는 표준 오프라인 RL(BC, IQL, CRL, SAC+BC 등)중 어느 것도, 1억 개 이상의 데이터셋(일반 오프라인 RL보다도 큼)에서도 모든 과제를 풀지 못했습니다. 게다가, 많은 문제에서 성능이 최적 이하에서 평탄화되었습니다. 다시 말해, 복잡한 롱-호라이즌 과제에서는 잘 스케일링되지 않았습니다.

질문이 나올 수 있습니다: 이 문제들은 정말 풀 수 있나요? 더 큰 모델, 더 오래 학습, 하이퍼파라미터 튜닝 등은 시도했나요? 논문에서 다양한 ablation, 통제실험을 해봤지만, 이들 어느 것도 근본적 해결책이 아니었습니다... 다만, 단 하나

초기 주장대로, 에피소드 길이(호라이즌) 및 이에 따른 편향 누적이 오프폴리시 RL 스케일링의 본질적 장애임을 확인하려 했습니다. 그래서, n-스텝 리턴, 계층적 RL 등, 실질적 TD 백업의 수를 줄일 수 있는 다양한 _호라이즌/길이 단축 기법_을 실험했습니다.

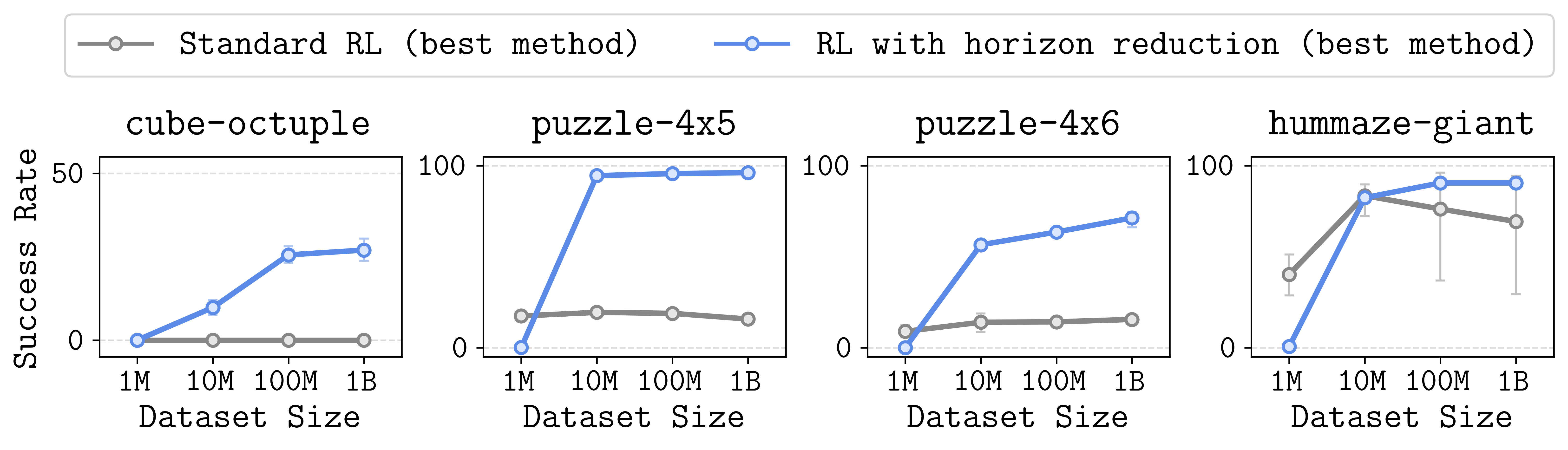

호라이즌 감소가 유일하게 전 과제에서 확장성을 크게 높였다.

결과는 유망했습니다! n-스텝 리턴과 같은 간단한 기법만으로도, 스케일링은 물론 _최종 성능(asymptotic performance)_까지 크게 향상되었습니다(단순 훈련 가속화가 아니라, 정말 근본적 효율증가임). 계층적(hierarchical) 방법은 효과가 더 컸고, 실험 전반에서 _유일_하게 항상 효과 있던 유일한 방법이었습니다. 즉, 단순히 데이터/컴퓨트만 늘리는 것으로는 에피소드 길이/편향 누적 문제를 못 해결합니다. _보다 근본적으로, 이 문제를 다루는 알고리즘 혁신이 필요_합니다.

호라이즌 감소가 Q-learning의 확장성을 여는 핵심 열쇠라는 걸 알았으니, 이제 끝난 걸까요? Q-learning만 스케일링하면 될까요? 제 생각에는 _이제 출발점에 도달_한 것뿐입니다. 물론 원인과 임시 처방(호라이즌 단축)이 나왔다는 건 긍정적입니다. 그러나 현재의 호라이즌 감소(계층화, n-스텝 리턴 등)는 근본적 치유가 아니라, 단지 문제를 상수 배 만큼 완화시켜줄 뿐입니다. 아직 RL에서 임의로 복잡/장기 문제에 스케일링 가능한 오프폴리시 알고리즘은 부재하다고 봅니다(혹은 발견되었으나 충분히 stress-test되지 않았을 수도). 이런 _확장 가능한 오프폴리시 RL_의 발견이 현대 머신러닝에서 가장 중요한 빈칸이라 생각합니다. 이것이 로봇, 언어 모델, agent, 실전 의사결정 등 훨씬 다양한 현실 문제의 자동화 해법을 제공할 것입니다.

마지막으로, 확장 가능한 오프폴리시 RL에 대한 제 생각을 다음과 같이 정리합니다:

위에서 제시한 구성은 이들 아이디어를 검증하기에 아주 좋은 실험 환경이 될 수 있습니다. 이미 복잡한 로봇 문제셋도 만들었고, 데이터셋도 공개했으며, 실제로 이론적으로 풀 수 있음을 검증했습니다. 과제를 임의로 더 어렵게(예: 큐브 개수 추가) 만들거나, 알고리즘 스케일링 한계까지 통제 실험도 할 수 있습니다. 코드를 최대한 깔끔하게 정리해서 공개했으니, 코드도 참고해 주세요!

질문/코멘트/피드백이 있다면 언제든 이메일/Twitter/X, 또는 컨퍼런스 현장에서 연락 주세요. 언젠가 _더 긍정적인 제목_으로 오프폴리시 RL 포스트를 쓸 수 있기를 희망합니다!

이 포스트에 많은 피드백을 준 Kevin Frans, 최홍석, Ben Eysenbach, Aviral Kumar, Sergey Levine께 감사드립니다. 본문의 일부는 저희 최근 논문, Horizon Reduction Makes RL Scalable 내용을 바탕으로 했습니다. 이 포스트의 견해는 전적으로 저자의 개인 의견이며, 공동저자의 의견과는 다를 수 있음을 밝힙니다.