AI 지원이 개발자의 새로운 코딩 기술 습득과 코드 이해에 어떤 영향을 미치는지, 무작위 대조 실험 결과를 통해 살펴본다.

URL: https://www.anthropic.com/research/AI-assistance-coding-skills

Title: AI 지원이 코딩 역량 형성에 미치는 영향

연구에 따르면 AI는 사람들이 자신의 업무 일부를 더 빠르게 수행하도록 돕습니다. Claude.ai 데이터에 대한 관찰 연구에서, 우리는 AI가 일부 작업을 최대 80%까지 더 빠르게 만들 수 있음을 발견했습니다. 하지만 이렇게 생산성이 증가하면 그에 따른 트레이드오프가 있을까요? 다른 연구들은 사람들이 AI 도움을 사용하면 자신의 일에 덜 몰입하고, 일을 수행하는 데 들이는 노력을 줄이며—즉, 사고를 AI에 맡기는 경향(인지적 오프로딩)이 있음을 보여줍니다.

이러한 인지적 오프로딩이 사람들이 업무를 통해 기술을 키우는 것을 방해하는지, 또는—코딩의 경우—자신이 구축하는 시스템을 이해하는 것을 방해하는지는 불분명합니다. 우리의 최신 연구는 소프트웨어 개발자를 참가자로 한 무작위 대조 시험(randomized controlled trial)으로, 직장에서 AI를 사용하는 잠재적 단점을 조사합니다.

이 질문은 학습을 촉진하는 AI 제품 설계, 직장에서의 AI 정책 접근, 더 넓게는 사회적 회복력 등 다양한 측면에서 광범위한 함의를 갖습니다. 우리는 AI 도구가 빠르게 표준이 된 분야인 코딩에 집중했습니다. 여기에는 잠재적 긴장이 있습니다. 코딩이 더 자동화되고 업무 속도가 빨라지더라도, 사람은 여전히 오류를 잡고, 출력을 유도하며, 궁극적으로 고위험 환경에 배치되는 AI에 대한 감독을 제공할 역량이 필요합니다. AI는 역량 개발과 효율 향상을 동시에 위한 지름길을 제공할까요? 아니면 AI 지원으로 인한 생산성 증대가 역량 개발을 약화시킬까요?

무작위 대조 시험에서 우리는 1) 소프트웨어 개발자가 AI 지원의 유무에 따라 새로운 기술(여기서는 Python 라이브러리)을 얼마나 빠르게 습득하는지, 그리고 2) AI 사용이 방금 작성한 코드를 이해할 가능성을 낮추는지 살펴보았습니다.

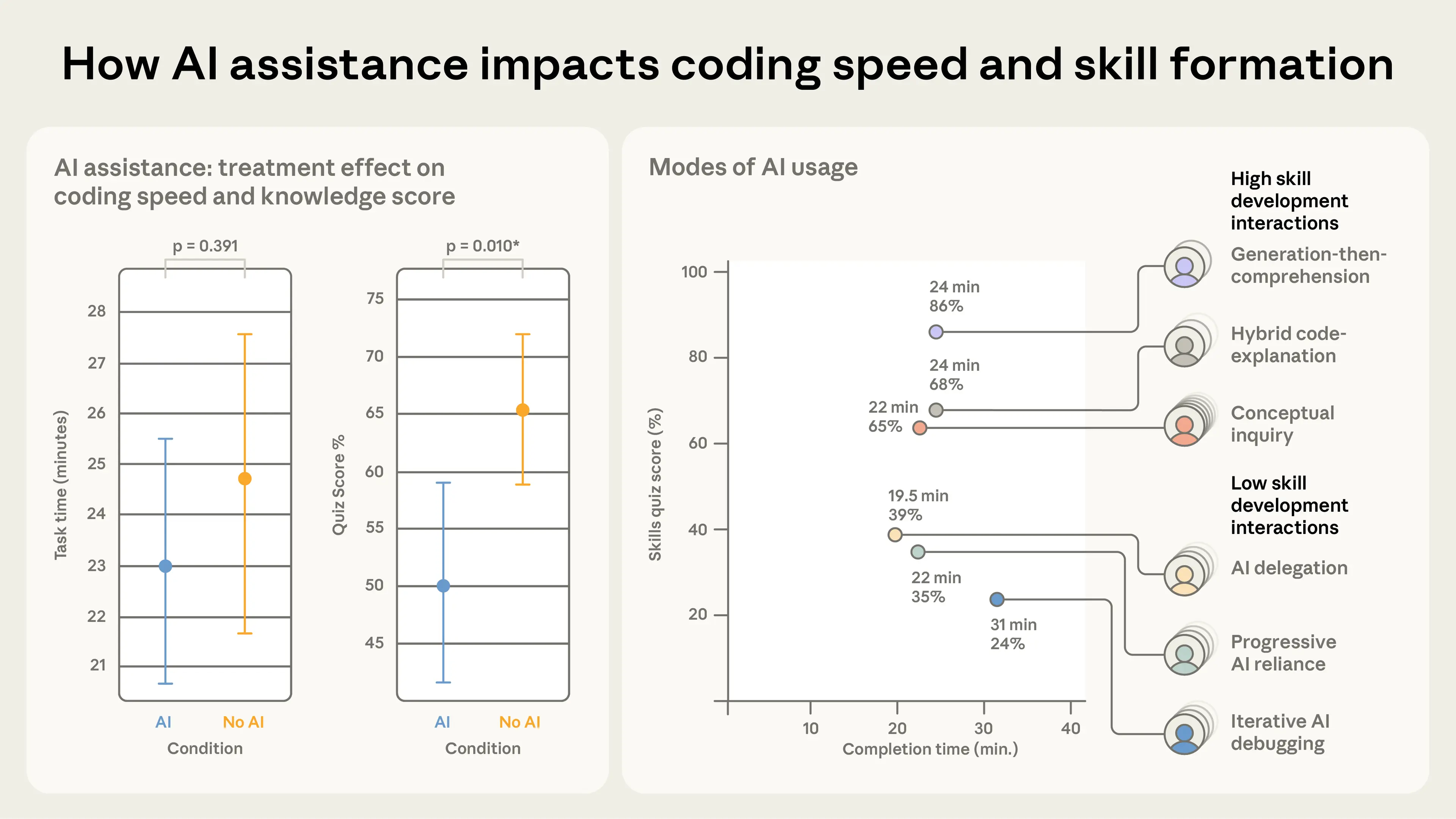

그 결과, AI 지원 사용은 숙련도(mastery)의 통계적으로 유의미한 감소와 연결되었습니다. 불과 몇 분 전에 사용했던 개념을 다루는 퀴즈에서, AI 그룹 참가자들은 손으로 직접 코딩한 그룹보다 17% 낮은 점수를 받았는데, 이는 문자 등급으로 거의 두 단계에 해당합니다. AI 사용은 과제를 약간 더 빠르게 완료하게 했지만, 이는 통계적 유의성 기준에는 도달하지 못했습니다.

중요하게도, AI 지원을 사용한다고 해서 반드시 점수가 낮아지는 것은 아니었습니다. 사람이 AI를 어떻게 사용하느냐가 얼마나 많은 정보를 유지하는지에 영향을 주었습니다. 더 높은 숙련도를 보인 참가자들은 단지 코드를 만들기 위해서가 아니라, 작업 중 이해를 구축하기 위해 AI 지원을 사용했습니다. 예를 들어, 후속 질문을 하거나, 설명을 요청하거나, 독립적으로 코딩하면서 개념적 질문을 던졌습니다.

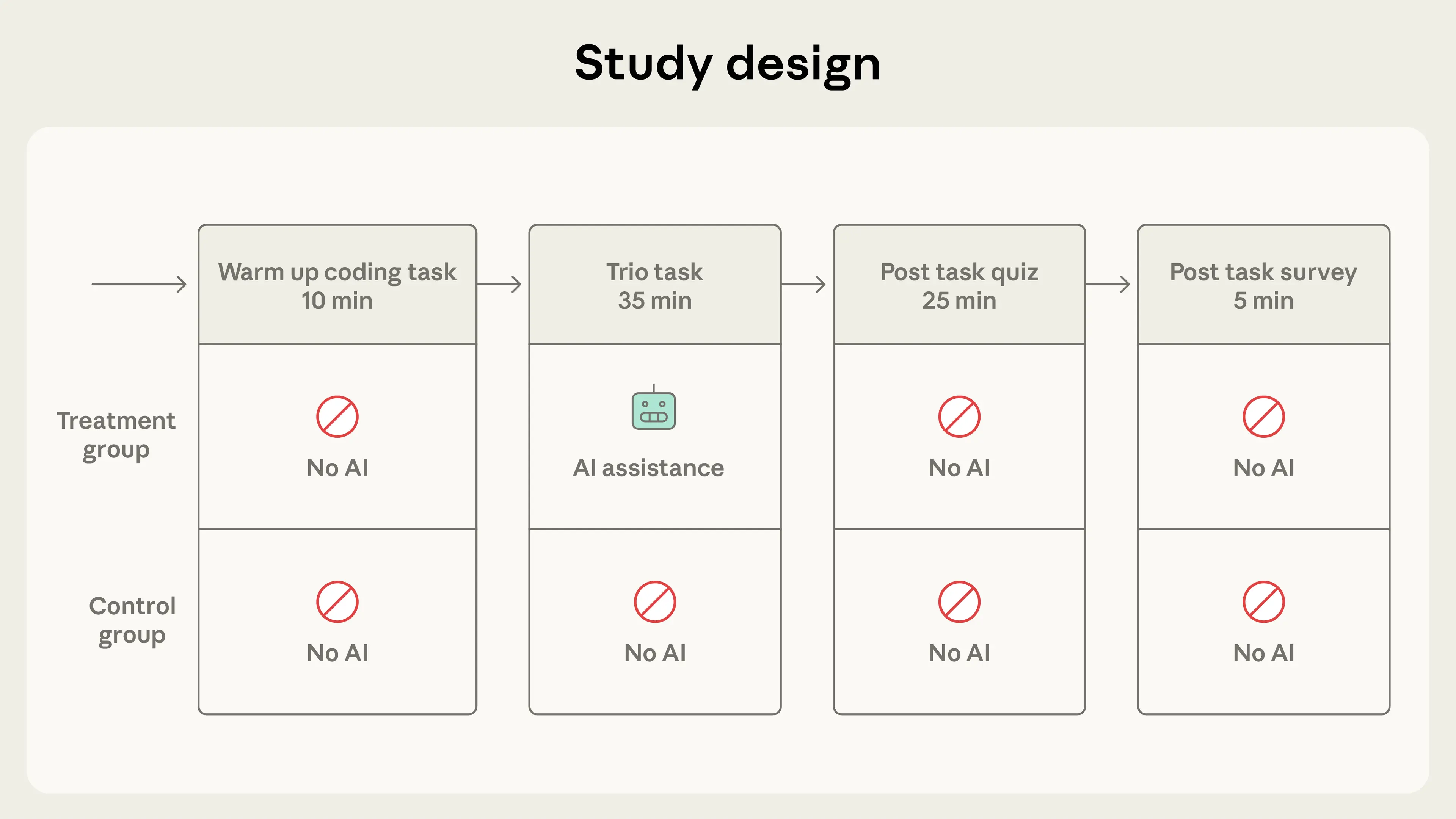

우리는 52명의(대부분 주니어) 소프트웨어 엔지니어를 모집했습니다. 이들은 모두 1년 이상 매주 최소 1회 Python을 사용해 왔습니다. 또한 AI 코딩 지원에 어느 정도 익숙하고, 과제가 기반으로 하는 Python 라이브러리 Trio에는 익숙하지 않도록 했습니다.

연구는 세 부분으로 나누었습니다. 워밍업, Trio를 사용해 서로 다른 두 기능을 코딩하는 본 과제(비동기 프로그래밍 관련 개념을 이해해야 하며, 이는 종종 직장에서 배우는 역량입니다), 그리고 퀴즈입니다. 과제 뒤에 퀴즈가 있음을 참가자들에게 알렸지만, 가능한 한 빠르게 작업하도록 권장했습니다.

우리는 코딩 과제를, 사람이 자기주도 튜토리얼을 통해 새 도구를 배우는 방식과 유사하게 설계했습니다. 각 참가자에게 문제 설명, 스타터 코드, 그리고 해결에 필요한 Trio 개념에 대한 짧은 설명을 제공했습니다. 또한 온라인 코딩 플랫폼을 사용했는데, 사이드바에 AI 도우미가 있고 참가자의 코드에 접근할 수 있으며, 요청받으면 언제든 정답 코드를 생성할 수 있었습니다.1

평가 설계에서는 코딩 역량의 숙련도를 평가하는 데 흔히 쓰이는 네 가지 질문 유형을 식별하기 위해 컴퓨터과학 교육 연구를 참고했습니다.

우리의 평가는 디버깅, 코드 읽기, 개념 문제에 가장 큰 비중을 두었는데, 이는 점점 더 AI 생성 코드가 될 가능성이 큰 결과물에 대해 감독을 제공하는 데 가장 중요하다고 보았기 때문입니다.

평균적으로 AI 그룹 참가자들은 약 2분 더 빨리 끝냈지만, 그 차이는 통계적으로 유의하지 않았습니다. 그러나 테스트 점수에서는 유의미한 차이가 있었습니다. AI 그룹의 퀴즈 평균은 50%였고, 손코딩 그룹은 67%였습니다. 이는 문자 등급으로 거의 두 단계 차이에 해당합니다(Cohen's d=0.738, p=0.01). 두 그룹 간 점수 격차가 가장 컸던 것은 디버깅 문항이었는데, 이는 AI가 코딩 역량 개발을 저해할 경우 코드가 틀렸을 때 이를 이해하고 왜 실패하는지 파악하는 능력이 특히 우려되는 영역일 수 있음을 시사합니다.

우리는 참가자들이 우리가 설계한 과제를 완료하기 위해 어떤 방식으로 작업했는지 이해하는 데 특히 관심이 있었습니다. 정성 분석에서는 화면 녹화를 수작업으로 주석 처리하여, 참가자들이 질의를 작성하는 데 얼마나 많은 시간을 썼는지, 어떤 유형의 질문을 했는지, 어떤 유형의 오류를 만들었는지, 그리고 실제로 코딩을 적극적으로 하는 데 얼마나 많은 시간을 썼는지 파악했습니다.

놀라운 결과 중 하나는 참가자들이 AI 도우미와 상호작용하는 데 소비한 시간이었습니다. 일부는 최대 11분(전체 허용 시간의 30%) 동안 최대 15개의 질의를 작성했습니다. 이는 AI 사용 참가자들이 평균적으로 더 빨리 완료하긴 했지만 생산성 향상이 통계적으로 유의하지 않았던 이유를 설명하는 데 도움이 됩니다. AI는 반복적이거나 익숙한 작업에 사용될 때 생산성을 유의미하게 높일 가능성이 더 크다고 봅니다.

예상대로, AI를 사용하지 않은 그룹은 더 많은 오류를 겪었습니다. 여기에는 문법 오류와 Trio 개념 오류가 포함되었고, 후자는 평가에서 테스트한 주제와 직접 대응했습니다. 우리의 가설은 더 많은 Trio 오류를 겪은 참가자들(즉, 통제 그룹)이 이러한 오류를 독립적으로 해결하면서 디버깅 역량을 향상했을 가능성이 높다는 것입니다.

그다음 우리는 참가자들을 AI와 상호작용한 방식에 따라 그룹화하여, 완료 시간과 학습에 서로 다른 결과를 낳는 구별되는 패턴을 식별했습니다.

저점수 상호작용 패턴: 저점수 패턴은 일반적으로 코드 생성이나 디버깅을 통해 AI에 크게 의존하는 것을 포함했습니다. 이 그룹의 평균 퀴즈 점수는 40% 미만이었습니다. 독립적 사고가 적고 인지적 오프로딩이 더 많았습니다. 우리는 이들을 다시 다음으로 나누었습니다.

고점수 상호작용 패턴: 우리는 평균 퀴즈 점수가 65% 이상인 행동을 고점수 패턴으로 보았습니다. 이 클러스터의 참가자들은 코드 생성과 개념 질의 모두에 AI를 사용했습니다.

우리의 정성 분석은 상호작용 패턴과 학습 성과 사이의 인과 관계를 도출하지는 않지만, 서로 다른 학습 성과와 연관된 행동을 보여줍니다.

우리의 결과는 직장에 AI를 공격적으로 도입하는 것—특히 소프트웨어 엔지니어링에서—트레이드오프가 있음을 시사합니다. 또한 모든 AI 의존이 동일한 것이 아니라, 효율을 내기 위해 AI와 상호작용하는 방식이 우리가 얼마나 배우는지에 영향을 준다는 점을 강조합니다. 시간 제약과 조직의 압박을 고려할 때, 주니어 개발자나 다른 전문직 종사자는 역량 개발—특히 문제가 발생했을 때 디버깅하는 능력—을 희생하면서까지 가능한 한 빨리 과제를 완료하기 위해 AI에 의존할 수 있습니다.

예비적이지만, 이 결과는 기업이 인간이 작성한 코드보다 AI가 작성한 코드의 비율을 더 높이는 방향으로 전환할 때 중요한 고려사항을 제시합니다. 생산성 이점은, 처음부터 주니어 엔지니어의 역량 개발이 AI 사용으로 저해되었다면 AI 작성 코드를 검증하는 데 필요한 역량을 희생하는 대가로 얻어질 수 있습니다. 관리자는 AI 도구를 대규모로 배치하는 방식을 의도적으로 고민해야 하며, 엔지니어들이 일하면서 계속 학습하고, 따라서 자신이 만드는 시스템에 의미 있는 감독을 행사할 수 있도록 보장하는 시스템이나 설계 선택을 고려해야 합니다.

소프트웨어 엔지니어링 초보 노동자나 어떤 산업의 초보 노동자에게도, 우리의 연구는 AI 도구와 함께 의도적으로 역량을 개발하는 가치에 대한 작은 증거로 볼 수 있습니다. 인지적 노력—심지어 고통스럽게 막히는 경험—은 숙련도를 기르는 데 중요할 가능성이 큽니다. 이는 개인이 AI와 함께 일하는 방식을 선택할 때, 그리고 어떤 도구를 사용하는지에 적용되는 교훈이기도 합니다. 주요 LLM 서비스는 이해를 촉진하도록 설계된 학습 모드(예: Claude Code Learning and Explanatory 모드 또는 ChatGPT Study Mode)도 제공합니다. 사람들이 AI를 사용하면서 어떻게 배우는지 아는 것은 우리가 AI를 설계하는 데도 도움이 됩니다. AI 지원은 사람이 더 효율적으로 일하도록 하면서 동시에 새로운 기술을 개발할 수 있게 해야 합니다.

이전 연구들은 AI가 코딩 생산성을 돕는지 혹은 방해하는지에 대해 엇갈린 결과를 보여왔습니다. 우리의 연구는 AI가 일부 업무 과제를 완료하는 데 걸리는 시간을 80% 줄일 수 있음을 발견했는데, 이는 여기 제시된 결과와 긴장 관계에 있어 보일 수 있습니다. 그러나 두 연구는 서로 다른 질문을 다루고 다른 방법을 사용합니다. 우리의 이전 관찰 연구는 참가자들이 이미 관련 역량을 갖춘 과제에서의 생산성을 측정한 반면, 본 연구는 사람들이 새로운 것을 학습할 때 어떤 일이 일어나는지 살펴봅니다. AI가 잘 발달한 역량에서는 생산성을 가속하면서도 새로운 역량의 습득은 저해할 가능성이 있지만, 이 관계를 이해하려면 더 많은 연구가 필요합니다.

이 연구는 인간-AI 협업이 노동자의 경험에 어떤 영향을 미치는지 밝히기 위한 첫걸음에 불과합니다. 표본은 비교적 작았고, 평가는 코딩 과제 직후의 이해도를 측정했습니다. 즉각적인 퀴즈 성과가 장기적인 역량 개발을 예측하는지 여부는, 이 연구가 해결하지 못한 중요한 질문입니다. 또한 향후 연구가 조사하길 바라는 많은 미해결 질문이 있습니다. 예를 들어 코딩을 넘어선 과제에서의 AI 효과, 엔지니어가 더 높은 유창성을 개발함에 따라 시간이 지남에 따라 이 효과가 약화되는지, 그리고 학습 과정에서 AI 지원이 인간 지원과 어떻게 다른지 등이 있습니다.

궁극적으로 AI가 있는 환경에서 역량 개발을 수용하려면, AI가 노동자에게 미치는 영향에 대해 더 확장된 관점이 필요합니다. AI가 강화된 직장에서는 생산성 향상이 중요하지만, 그 향상이 의존하는 전문성의 장기적 발전 역시 중요합니다.

자세한 내용은 전체 논문을 읽어보세요.

이 프로젝트는 Judy Hanwen Shen과 Alex Tamkin이 주도했습니다. 이 블로그 글에 대한 편집 지원은 Jake Eaton, Stuart Ritchie, Sarah Pollack이 제공했습니다.

Anthropic Safety Fellows Program을 통해 이 프로젝트가 가능하도록 해준 Ethan Perez, Miranda Zhang, Henry Sleight에게 감사드립니다. 또한 실험 설계 피드백을 제공한 Matthew Jörke, Juliette Woodrow, Sarah Wu, Elizabeth Childs, Roshni Sahoo, Nate Rush, Julian Michael, Rose Wang에게도 감사드립니다.

@misc{aiskillformation2026,

author = {Shen, Judy Hanwen and Tamkin, Alex},

title = {How AI Impacts Skill Formation},

year = {2026},

eprint = {2601.20245},

archivePrefix = {arXiv},

primaryClass = {cs.LG},

eprinttype = {arxiv}

}